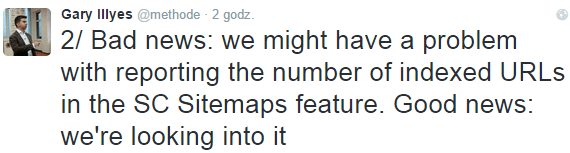

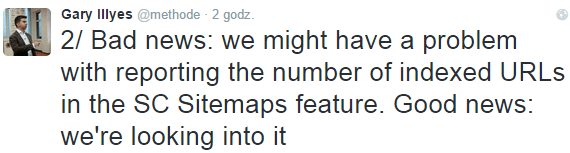

Jak donosi Gary Illyes, w Google Search Console pojawiły się problemy z raportowaniem ilości zaindeksowanych przez wyszukiwarkę podstron.

Tym samym ilości podane w sekcji "Mapy witryn" i ogromne dysproporcje pomiędzy ilością podstron zaindeksowanych, a tych ujętych w xmlowej mapie strony, nie muszą być powodem do zmartwień.

Z moich obserwacji wynika, że duża część różnic (choć nie wszystkie) wynika z omawianego błędu. Dla przykładu ilość zaindeksowanych podstron serwisu z powyższej grafiki zbliża się do 1500, podczas gdy Search Console wskazuje jedynie 723.

Jak sprawdzić ilość zaindeksowanych podstron?

Do momentu naprawy błędu w Search Console, w badaniu ilości zaindeksowanych podstron pomogą nam:

- zapytanie site:nazwadomeny.pl do wyszukiwarki Google (wartość szacunkowa),

- Website SEO Checker - aplikacja online, gdzie aby uzyskać ilość zaindeksowanych adresów podstron wystarczy wpisać adres strony głównej,

- Google Index Checker - rodzima, polska aplikacja desktopowa, do której wystarczy wczytać mapę XML, a program zwróci nam adresy zaindeksowane oraz niezaindeksowane,

- Scrapebox - płatna (97$ na dzień dzisiejszy) aplikacja desktopowa, która po wgraniu listy adresów (np. wyciągniętych z mapy XML) zwróci nam informację o stanie indeksacji.

1 Gary Illyes, Webmaster Trends Analyst z Google w Szwajcarii, od czasu przedłużającego się urlopu Matta Cuttsa, jest obok Johna Muellera osobą kontaktową pomiędzy Google, a Webmasterami.

Na jego Twitterze pojawiają się informacje dotyczące bieżących zmian w algorytmie Google, nowych funkcjonalności i komunikatów w Search Console.

28 lipca w Google Search Console (Webmaster Tools) pojawiły się nowe komunikaty dotyczące braku dostępności plików JavaScript i CSS (arkusze styli) dla robotów Google.

Wiadomości te skierowane są do właścicieli/webmasterów witryn, które w pliku robots.txt zawierają zapisy przypominające poniższe:

Wiadomości te skierowane są do właścicieli/webmasterów witryn, które w pliku robots.txt zawierają zapisy przypominające poniższe:

Disallow: /js/

Disallow: /css/

lub

Disallow: .css

Disallow: .js

W przypadku popularnych systemów zarządzania treścią, pliki CSS i JS znajdują się głównie w katalogu "includes", stąd błędy mogą generować również poniższe komendy w robots.txt:

WordPress

Disallow: /wp-includes/

Joomla

Disallow: /includes/

Blokady plików *.css i *.js, niegdyś będące popularnym rozwiązaniem, mającym na celu przyspieszenie czasu ładowania się strony dla Googlebotów, dziś nie są mile widziane przez wyszukiwarkę.

Jak udzielić Googlebotowi dostępu do plików CSS i JS?

Jeśli komunikat pojawił się również w Waszym Google Search Console, możecie w prosty sposób poprawić wskazany błąd dodając zapis:

User-Agent: Googlebot

Allow: .js

Allow: .css

lub usuwając istniejące zapisy dotyczące plików CSS i/lub JS.

Pobierz jako Google

Po aktualizacji pliku robots.txt nie zapomnijcie o skorzystaniu z funkcji "Pobierz jako Google" (Search Console/ Indeksowanie/ Pobierz jako Google) w celu poinformowania wyszukiwarki o dokonanych zmianach.

Wiadomości te skierowane są do właścicieli/webmasterów witryn, które w pliku robots.txt zawierają zapisy przypominające poniższe:

Wiadomości te skierowane są do właścicieli/webmasterów witryn, które w pliku robots.txt zawierają zapisy przypominające poniższe: